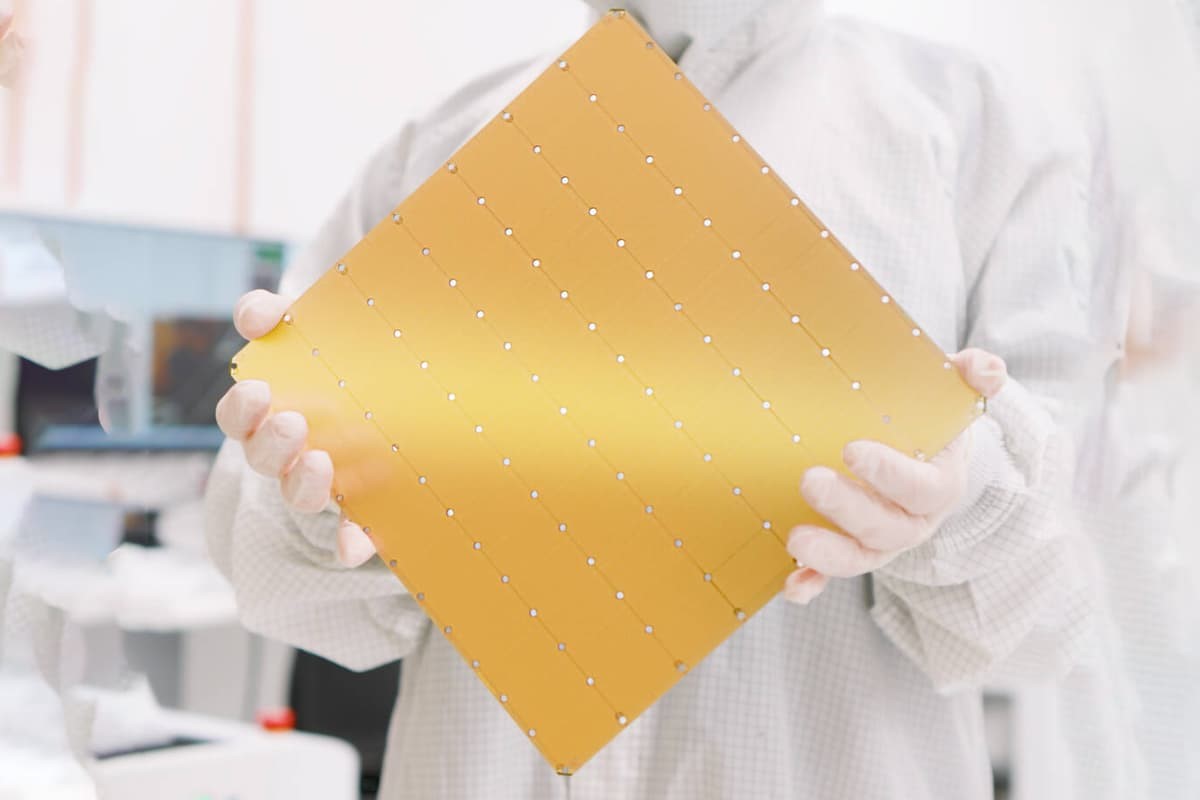

Wafer

Scale Engine (WSE-3) là con chip AI nhanh nhất thế giới (Ảnh: Cerebras Systems)Trước

khi hệ thống AI có thể tạo ra một đoạn video ngắn dễ thương nhưng kỳ quặc về một

con mèo đánh thức chủ nhân của nó, nó cần phải được huấn luyện (train) bằng một

lượng dữ liệu đáng kinh ngạc, tiêu tốn nhiều hơn năng lượng sử dụng cho 100 hộ

gia đình trong quá trình đó. Nhưng con chip mới và các máy tính được tích hợp

nó sẽ giúp tăng tốc quá trình này và làm cho nó hiệu quả hơn.

Mỗi

con chip WSE-3, có kích thước bằng một chiếc hộp bánh pizza, chứa đến 4 nghìn tỷ

bóng bán dẫn, mang lại hiệu suất gấp đôi so với mẫu trước đó của công ty (cũng

là mẫu giữ kỷ lục thế giới trước đó) với cùng chi phí sản xuất và mức tiêu thụ

điện năng. Khi những thứ này được tích hợp vào hệ thống CS-3, rõ ràng chúng có

thể cung cấp hiệu suất làm việc tương đương một căn phòng chứa đầy máy chủ

trong một thiết bị có kích thước bằng một chiếc tủ lạnh mini.

Cerebras

cho biết CS-3 đang chạy 900.000 nhân AI và 44 GB SRAM trên chip, cung cấp hiệu

suất AI cao nhất lên tới 125 petaFLOPS. Về lý thuyết, điều đó đủ mạnh để đưa nó

vào danh sách 10 siêu máy tính hàng đầu thế giới – mặc dù nó chưa được thử nghiệm

trên các tiêu chuẩn đó, do đó chúng ta chưa thể chắc chắn nó thực sự hoạt động

tốt như thế nào.

Để

lưu trữ tất cả dữ liệu đó, các tùy chọn bộ nhớ ngoài bao gồm 1,5 TB, 12 TB hoặc

cực lớn đến 1,2 Petabyte (PB), tức là 1.200 TB. CS-3 có thể huấn luyện các mô

hình AI liên quan đến tới 24 nghìn tỷ tham số – để so sánh, hầu hết các mô hình

AI hiện có hàng nghìn tỷ tham số, trong đó GPT-4 ước tính xử lý tối đa khoảng

1,8 nghìn tỷ tham số. Cerebras cho biết CS-3 sẽ có khả năng huấn luyện mô hình

một nghìn tỷ tham số dễ dàng như các máy tính dựa trên GPU hiện tại huấn luyện

mô hình một tỷ tham số.

CS-3 dễ dàng lắp đặt vào hạ tầng trung tâm dữ liệu tiêu chuẩn

Nhờ

quy trình sản xuất wafer của chip WSE-3, CS-3 được thiết kế để có thể mở rộng,

cho phép tối đa 2.048 đơn vị được nhóm lại với nhau thành một siêu máy tính khó

có thể đo được. Con số đó có khả năng lên tới 256 exaFLOPS, trong khi đó các

siêu máy tính hàng đầu trên thế giới hiện vẫn đang hoạt động với hơn một

exaFLOP một chút. Công ty tuyên bố mức sức mạnh đó sẽ cho phép nó huấn luyện mẫu

Llama 70B từ đầu chỉ trong một ngày.

Có

cảm giác như các mô hình AI đang phát triển với tốc độ đáng kinh ngạc và sẽ chỉ

đi lên. Bất kể bạn làm công việc gì, có vẻ như các hệ thống AI sẽ phục vụ công

việc đó và thậm chí cả sở thích của bạn nhanh hơn bao giờ hết.

LH

(New Atlas)